SearchGPT : le moteur de recherche par ChatGPT va-t-il supplanter Google (et le SEO) ?

4 nov. 2024

SEO

Publié le 18 juil. 2022 - 6 minutes de lecture

L'analyse de logs doit, aujourd'hui, être une priorité dans l'élaboration de stratégies SEO. En quoi cela consiste ? Que faut-il regarder ?

Au programme

Le référencement naturel, ou SEO, fait généralement référence à l’optimisation du contenu, ou au maillage interne et externe. Mais beaucoup ignorent l’importance de l’analyse des performances SEO d’un site, qui ont une influence directe sur le comportement des robots de Google, et donc du positionnement des pages dans la SERP. Essayons alors de comprendre le crawl Google, et l’importance de l’analyse de logs SEO pour déjouer les rouages du Googlebot.

Pour que votre site web soit bien référencé dans la page du moteur de recherche de Google (SERP), les robots de Google, ou Googlebot, parcourent très régulièrement les pages de votre site pour en tirer différentes informations, indexer les pages de votre site sur le web, les évaluer, et les positionner dans la SERP.

L’analyse de logs est ici intéressante puisqu’elle permet d’inverser le rapport de force entre vous et le Googlebot, pour comprendre ce qui ne lui plaît pas, et ainsi faire le nécessaire pour le satisfaire et ranker dans la SERP.

L’analyse de logs permet de tracker à votre tour l’activité et la fréquence du Googlebot sur votre site, en regardant les traces qu’il a laissé sur votre serveur.

L’analyse de logs permet de tracker et d’analyser la moindre milliseconde que Google a passée sur votre serveur, pour ensuite en tirer des conclusions sur la performance de votre site web et les éventuels problèmes structurels.

Chaque action du Googlebot est ainsi enregistrée dans un fichier de logs sur le serveur, tout comme les actions de tous les utilisateurs du site. En allant isoler spécifiquement les actions du Googlebot sur le serveur, on comprend son comportement, ce qu’il a cherché à faire, et là où il a bloqué.

L’intérêt majeur est donc de pouvoir réparer les défauts du site qui empêchent Google de mieux référencer votre site.

Pour analyser les logs d’un site Internet, il existe deux solutions :

La configuration de l’analyse de logs SEO avec un outil spécifique est plutôt simple, puisqu’il suffit d’ajouter un script PHP sur un fichier du CMS, et d’ajouter un script à la racine du site, qui va authentifier la propriété du site.

Bon à savoir : pour certains sites, qui ont une politique de sécurité plus stricte que la moyenne (banque, assurance…), il est possible que la solution n’accepte pas d’exécuter des scripts PHP faisant sortir des données du serveur. Dans ce cas-là, il faut paramétrer le dash server, qui va exporter automatiquement à heure fixe l’intégralité des actions de Google et les stocker sur un serveur FTP qui est mis à disposition de la solution.

Une fois la solution achetée, il n’y a plus qu’à installer les scripts, et on retrouve ensuite les statistiques du site web directement dans la solution choisie (SEOlyzer, Botify…). Il faut quand même faire quelques paramétrages pour que toutes les données voulues remontent bien dans les fichiers logs. Par exemple, certaines données sont sécurisées par le serveur pour éviter les fuites et le piratage. Il faut alors désactiver cette fonction, ou plus raisonnablement, faire une exception pour la solution d’analyse.

Pour que l’outil d’analyse puisse travailler correctement, il est important d’avoir bien préparé son arborescence d’url, et avoir un découpage clair et lisible de la profondeur de pages et du contenu auquel est rattaché la page.

Exemple : pour une voiture sur un site de constructeur automobile, la page d’un modèle en particulier devra avoir une url du type Nom de domaine / automobile / marque / modèle.

Sans ça, il va être difficile de configurer les catégories de pages, et de segmenter l’analyse SEO. Il faut également vérifier la configuration du robot et les consignes qu’on lui donne, car si on interdit à Google d’accéder à certaines pages qu’on souhaite analyser en particulier, rien n’apparaîtra dans l’analyse de logs, ce qui peut ne pas être très pertinent.

Avec l’analyse de logs, on observe la partie immergée de l’iceberg. Quand on audite un site en le parcourant des yeux, ou quand on lance un crawler pour identifier ce qui va et ne va pas, on relève forcément un certain nombre d’erreurs. Sauf que Google, moteur de recherche le plus utilisé au monde, c’est plus fort que vous ! Il va réussir à retrouver des erreurs qu’on n’aura pas vues, au fin fond de votre code, par exemple, ou sur des appels de ressources.

La première chose à faire, est donc de parcourir l’ensemble des onglets de la solution, pour rechercher un problème critique évident.

De manière plus routinière, il faut regarder régulièrement les réponses de codes http, pour vérifier s’il n’y a pas des erreurs 404 qui n’ont pas été remontées par la search console ou par Screaming Frog.

Ensuite, vous pourrez comparer les codes http et les erreurs 404 aux résultats de la search console et de Screaming Frog pour voir si on a des pages orphelines (pas parcourues par Google, et donc inutiles ou inefficaces). Si un mauvais lien est fait, cela peut fortement desservir votre site web.

Enfin, il est conseillé de surveiller les bad bots, des bots qui prétendent être Google, mais qui ne le sont pas. Ce n’est généralement pas très méchant, et leur action est limitée, mais cela peut aussi mener à des tentatives de piratage. Il suffit alors de bannir ces IP pour interdire l’accès au site.

Toutes ces erreurs peuvent sembler anodines, elles sont pourtant à traiter, car elles font perdre du temps dans le traitement du site par Google. Et c’est là le gros enjeu du SEO : gérer le budget crawl (nombre de pages du site que Google visite chaque jour).

Ainsi, si un site est bien optimisé, sans trop d’erreurs, les robots de Google vont parcourir un maximum de pages sur un temps imparti, et reviendront de plus en plus souvent. Si l’optimisation est mauvaise, Google va perdre du temps, va parcourir moins de pages, reviendra moins souvent. Au final, le site va finir par descendre dans les résultats de la SERP.

On peut aussi aider Google à ne pas perdre de temps sur un site, en utilisant le no follow, pour dire à Google « ne va pas sur cette page, tu perds ton temps », ou le no index que la page ne soit même pas indexée dans la SERP de Google.

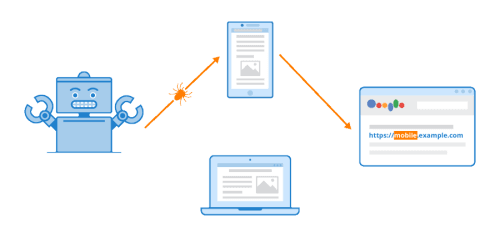

Bon à savoir : la majorité des analyses du robot Google se fait sur la version mobile d’un site. Il est donc impératif d’avoir un site optimisé pour mobile (responsive). Si Google reste en mode « desktop », cela met probablement en lumière un problème d’optimisation du site sur mobile et une mauvaise expérience utilisateur.

L’analyse de logs est une nécessité pour toute refonte, avoir un avant/après précis, pour une création de site ou pour une reprise de site. C’est le seul et unique moyen de voir le comportement de Google sur un site. Un audit SEO sans analyse de logs, en 2022, est donc incomplet, car de gros problèmes peuvent passer inaperçus et entraîner des problèmes de performances et de positionnement dans la SERP.

Rencontrons-nous

Pour développer ensemble votre performance digitale !